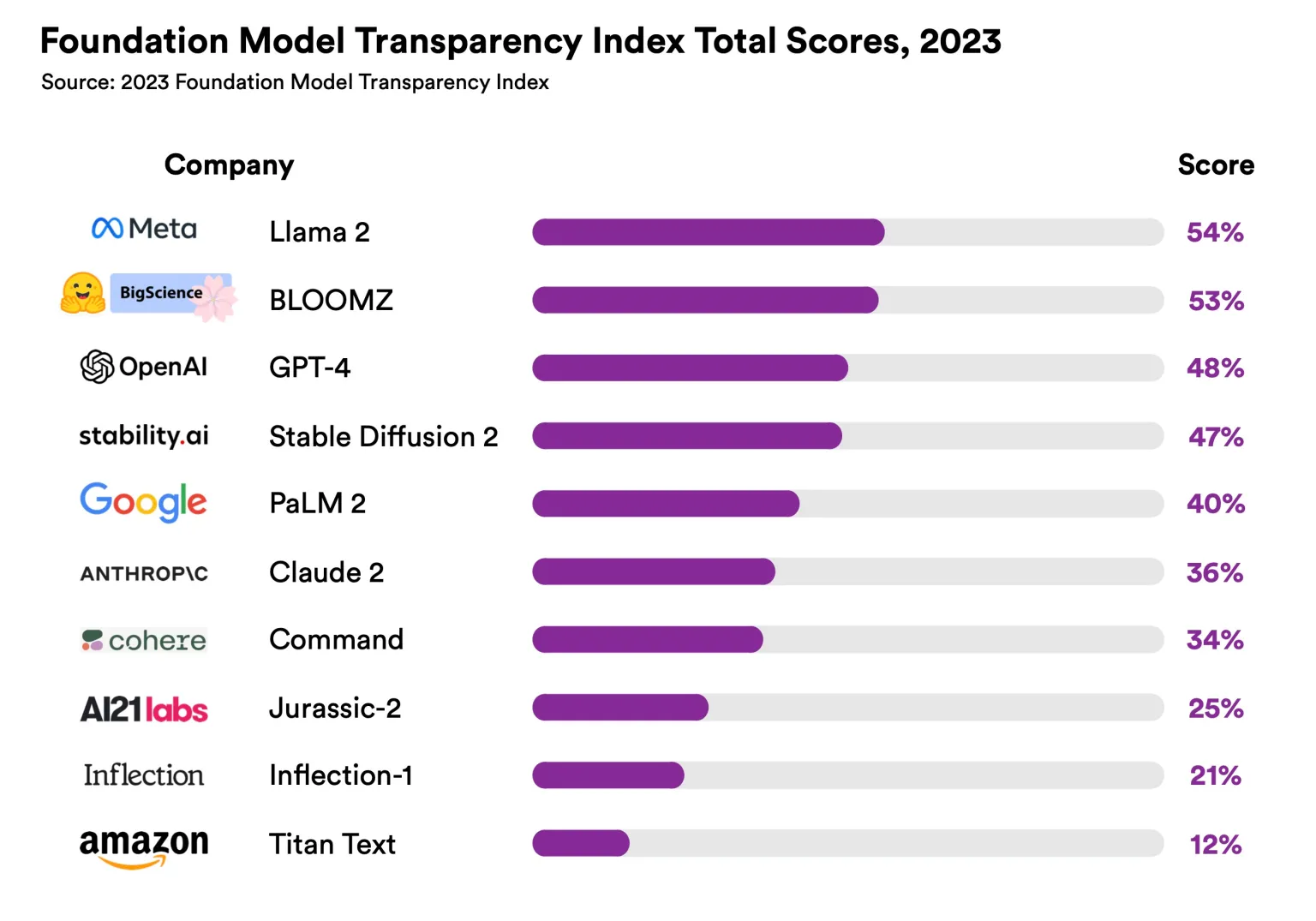

Исследование: что скрывают от нас GPT-4, Llama 2 и другие языковые ИИ-модели

На днях Стэнфордский университет опубликовал результаты исследования: ученые изучили большие языковые ИИ-модели и выяснили, насколько прозрачны эти системы. Ответ — ни одна из известных моделей не приблизилась к полной прозрачности. Максимальный показатель индекса прозрачности у Llama 2 (Meta) — 54 балла. GPT-4 на третьем месте.

Объектами исследования были модели таких компаний, как OpenAI, Anthropic, Google, Meta, Amazon, Inflection, Meta, AI21 Labs, Cohere, Hugging Face, Stability.

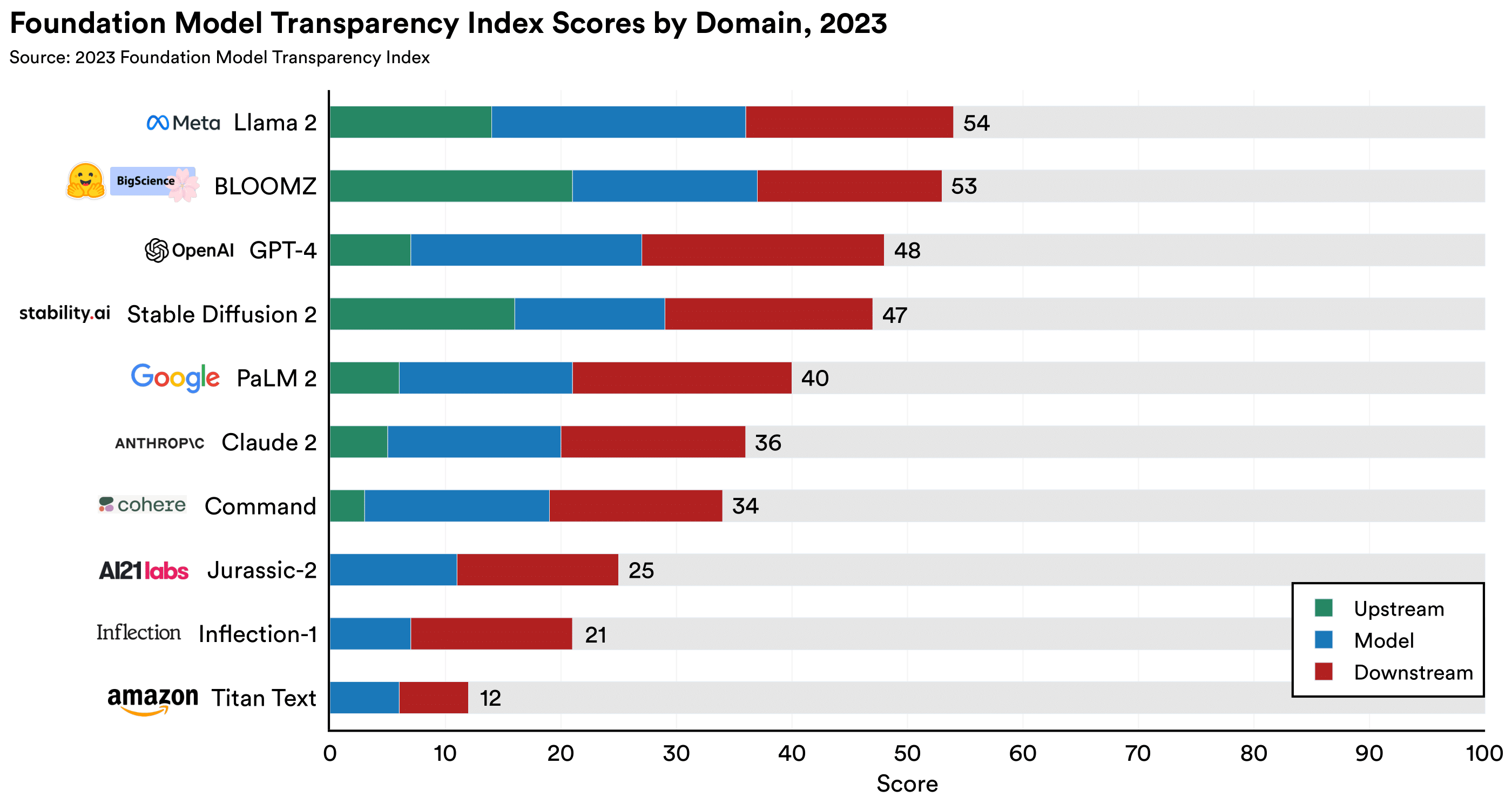

Директор Центра изучения базовых моделей (ЦИБМ) Перси Лянг подчеркивает, что дело не только в открытом коде. В исследовании рассматривалась «прозрачность» в широком смысле: какие данные, как и кем использовались при создании модели.

Модели оценивались по 100 параметрам.

• Высокоуровневые: как собирались данные, их источники и размеры, использование человеческих ресурсов

• Связанные с устройством модели: архитектура, возможности, риски

• Низкоуровневые: как модель используется и влияет на пользователей

Источник: crfm.stanford.edu/fmti

Индекс описывает ситуацию в 2023 году, и многие компании просто не были готовы к такой оценке. Перси Лянг считает, что ситуация улучшится в ближайшие несколько месяцев.